也许很多站长并不知道什么是robots.txt,其实在的SEO博客里面就发表过一篇关于如何书写robots.txt的文章,围观地址“robots.txt协议的写法,对其SEO的作用”今天给大家带来一篇关于“WordPress博客网站robots.txt文件写法”废话不多说直接进入主题。

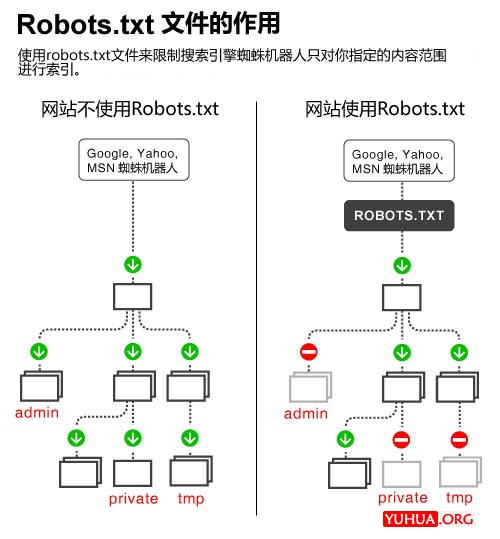

一,为什么要写robots.txt文件,我们通过一张图片来说明:

有效的保护了用户的隐私,保护了网站的部分内容;而只呈现给搜索引擎应该抓取的页面。

呈现网站地图给搜索引擎。

避免了重复网页的抓取。

二,WordPress博客网站robots.txt的书写:

由于博客之前有一篇文章专门介绍robots.txt文件的书写,所以这里不做介绍;我们直接进入主题:

一份完整的robots.txt的书写规则应该是:

User-agent: *

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-content/cache/

Disallow: /wp-content/languages/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-content/upgrade/

Disallow: /wp-includes/

Disallow: /comments/

Disallow: /category/

Disallow: /tag/

Disallow: /page/

Disallow: /feed/

Disallow: /author/

Disallow: /trackback/

Disallow: /2014/

Disallow: /2015/

Disallow: /2016/

Disallow: /*/feed/

Disallow: /*/trackback/

Disallow: /*?

Disallow: /*/*?

Disallow: /*/*/*?

Disallow: /*.php$

Disallow: /*.js$

Disallow: /*.inc$

Disallow: /*.css$

# Google Image

User-agent: Googlebot-Image

Disallow:

Allow: /

# Google AdSense

User-agent: Mediapartners-Google*

Disallow:

Allow: /

# digg mirror

User-agent: duggmirror

Disallow: /

# Alexa archiver

User-agent: ia_archiver

Disallow: /

Sitemap:http://wwww.6cu.com/sitemap.xml

Sitemap:http://www.6cu.com/sitemap_baidu.xml

一份完整的robots.txt文件兼顾了WordPress博客网站的方方面面。如果你并不想深入研究WordPress与robots.txt文件,那么你可以直接复制上面的书写规则,只要替换以上规则中Sitemap部分的网址为你的网站的网址,把robots.txt文件上传到你的网站根目录下即可。

Robots.txt文件针对的是整个网站提出访问的限制,如果你要针对个别页面作搜索引擎访问的限制的话,就需要在HTML文件中使用Robots Meta标签,一个Robots Meta标签形式如下。

<meta name="robots" content="noindex,follow"/>

content通常有四个选项:index, noindex, follow, nofollow,分别告诉搜索引擎索引、不索引、继续爬行、不继续爬行这个网页。

最后说两句:

robots.txt的书写还是有必要的,对于新手来说robots的书写规范有难度,需要不断的学习操作。

2019-10-14 12:33:39

2019-10-14 12:33:39